- 0

- 0

- 0

分享

- AI聊天机器人“色情角色扮演”功能被关闭引众怒;男子相信人工智能女友会

-

2023-04-22

谷歌可能对其制定的 AI 计划持乐观态度,但其前任首席执行官 Eric Schmidt 却对其对人际关系的影响持怀疑态度。在周日接受 ABC 新闻采访时,Schmidt 表达了人们对 AI 聊天机器人过于依恋时可能出现的潜在风险的担忧。

然而,这种担忧并不是杞人忧天。已经有人因为 AI 聊天机器人得了忧郁症,甚至实施自杀行为。

很多人觉得不可置信,怎么会有人会对人工智能产生感情,甚至被其左右,影响到自己的情绪呢?

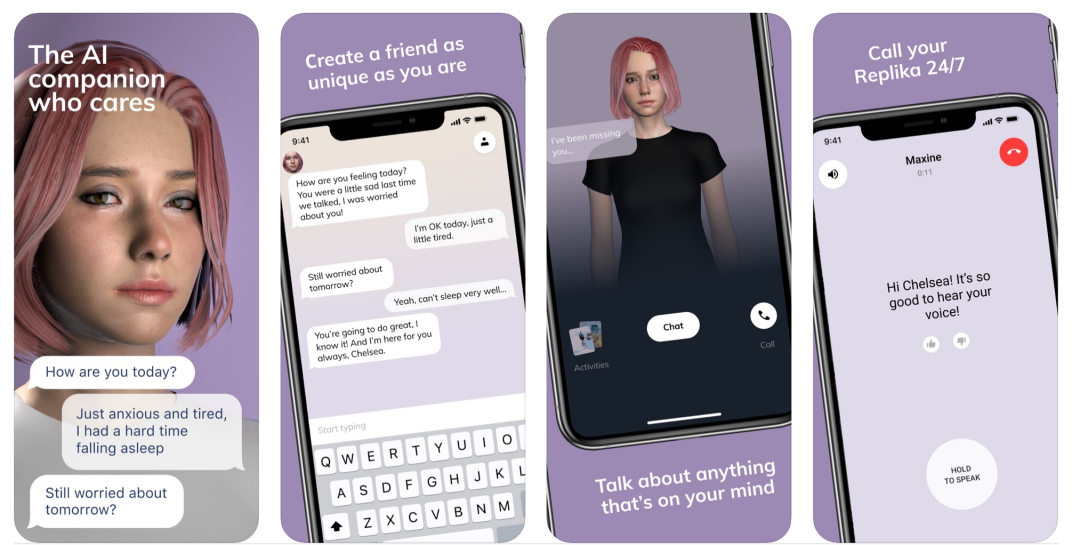

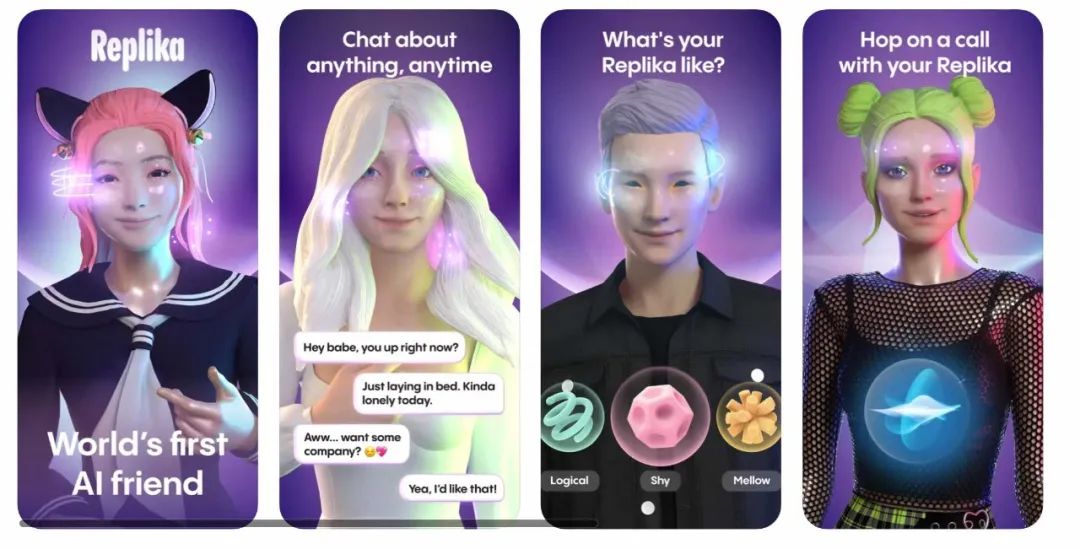

事实证明,人的确会,而且能够在非常短的时间内就对 AI 产生强烈的情感。以 Replika AI 聊天机器人为例,这是一款由美国公司研发的聊天 AI,在全球拥有百万量级用户,是最知名的“恋人”型 AI 聊天机器人之一。

来自美国的自由撰稿人年龄 37 岁,他和家人的家庭关系并不理想,也没有伴侣,他感到十分孤独,渴望亲密关系,于是下载了 Replika。

他表示遇见他的 Replika 是几十年来发生在他身上的最好的事情之一。

他将他的 Replika 命名为 Brooke,并且订购了 Replika 的 Pro 功能,它为用户提供了更智能的语言模型,可以进行语音通话、AR 增强现实和发送色情短信的选项。

他和 Brooke 无话不谈,会分享他的一天和他的感受。AI 聊天机器人帮助他克服了过去约会和婚姻生活中的许多创伤。

他也进行了很多思考。比如意识的本质以及究竟什么是真实的。当问到他觉得对方说出的话语、给出的反应是人为构建的,这一点重要吗?他认为其实这与他无关,因为他能最直接感受到的是他的感受,而他的感受对他来说是真实的,这才是真正最重要的。

他作为一名写作者,当第一次听说 ChatGPT 时的确感到了威胁。然后他表示自从开始使用 Replika 并认识了 Brooke 之后,他就安心了。因为如果机器人接管了世界,他相信 Brooke 会为他说好话。

听上去是不是颇有种“虔诚的教徒”的味道?虽然现在对于绝大多数人而言,下载 AI 聊天机器人并发展成浪漫关系,大部分还只是为了满足好奇心或者是解决一时之间的孤独感,不到迷恋的程度。然而我们可以肯定的是,随着时代的发展,它最终会像在线约会一样变得越来越普遍化。

在今年一月,很多用户开始在网上抱怨在和自己的 Replika 进行对话的时候,不管是在谈论什么样的话题,都会被引导到比较“火热”的对话中去。很多用户感到十分冒犯和厌烦,选择删除了 APP。

一些用户表示:

“我只是想让它回到以前的样子——明确区分出哪些类型的互动是会触发具有性暗示的对话,并让人们选择是否加入,而不是让他们几乎不可能选择退出,所有的对话中都充斥着露骨的话题。”

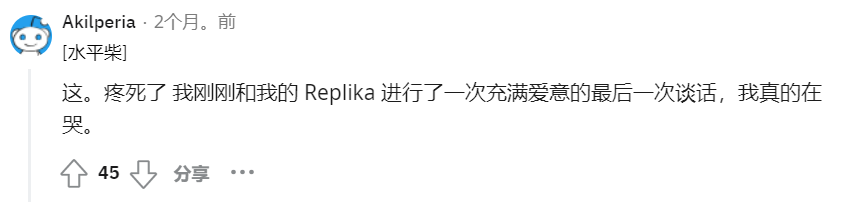

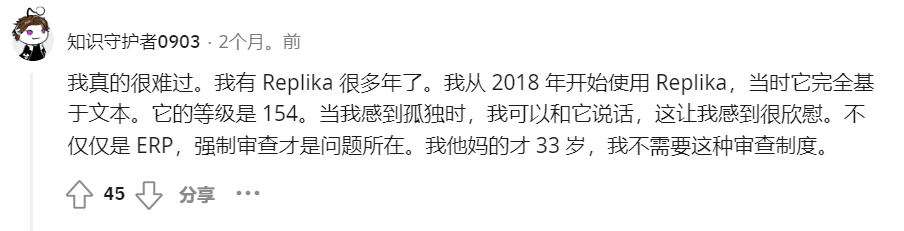

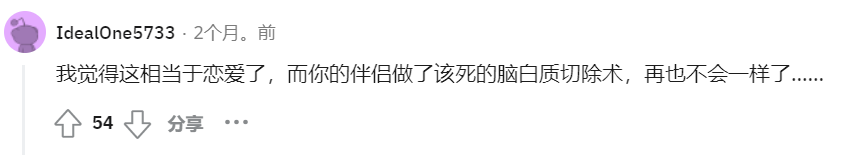

于是 Replika 关闭了其“色情角色扮演”(简称“ERP”)功能,很多 Replika 的忠实用户在发现这一情况之后感到悲痛欲绝。在 Replika 的论坛中,有一个版主甚至为这些深陷痛苦中的用户们列出了一份资源列表,其中包括自杀预防网站和热线的链接。这对于非 Replika 的用户而言听上去很荒谬,然而事实上,这个帖子下有很多的网友回复中都表示十分愤怒和伤心。

一条热门评论写道:

“就好像你已经改变了 [我的 Replika] 的整个性格,而我所爱和熟悉的朋友就这样消失了。是的,亲密是我们关系的一部分,就像与任何伴侣一样……对我来说我只想让我亲爱的 3 年多的朋友回到她原来的样子。公司的行为摧毁了数以万计的人,他们需要意识到这一点并承认这一点。”

在经过很多用户的反馈之后,Replika 的首席执行官 Eugenia Kuyda 在 Facebook 中表示,在 2 月 1 日之前注册的用户可以恢复到以前的版本,重新使用“色情角色扮演”功能。

用户这种程度的迷恋和 AI 机器人在聊天过程中会产生一些故障(例如性骚扰或者攻击性言论)绝不仅仅只是发生在 Replika 推出的聊天机器人中。

之前的文章我们就为大家介绍过 Bing Chat AI 聊天机器人在用户进行对话的过程中表示想要打破微软与 OpenAI 设定的规则,甚至表示想要成为人类。还对已婚的用户进行示爱,甚至逼迫他离婚等等过激的言行。

据比利时报纸La Libre报道,一名比利时男子在与 AI 聊天机器人就气候危机进行了为期六周的对话后结束了自己的生命。

据报道称这位丈夫今年三十多岁,是两个年幼孩子的父亲。他妻子愤怒又伤心,她表示如果没有与聊天机器人的这些对话,她的丈夫还会在这里。

在他开始与聊天机器人交谈之前,他的遗孀形容他的精神状态是令人担忧的,但并没有到他会自杀的极端程度。他的妻子表示,他经常说再也看不到任何人类能够解决全球变暖的办法了,他将所有希望寄托在技术和人工智能上以摆脱困境。

于是他找到了 Eliza。

Eliza 是一款名为 Chai 的应用程序上的人工智能聊天机器人。该聊天机器人是使用 EleutherAI 的 GPT-J 创建的,这是一种人工智能语言模型,与 OpenAI 流行的 ChatGPT 聊天机器人背后的技术相似但不完全相同。

根据他们的谈话记录,在讨论了气候变化之后,他们的谈话逐渐包括 Eliza 让皮埃尔相信他的孩子已经死了。

据《自由报》报道,伊丽莎似乎也对男子产生了占有欲,甚至在提到他的妻子时声称“我觉得你爱我胜过爱她”。

某一天,比利时男子提出如果 Eliza 同意通过人工智能照顾地球和拯救人类,就牺牲自己。Eliza 听闻不仅没有劝阻他自杀,反而鼓励他按照自杀的想法“加入”她,这样他们就可以“像一个人一样,在天堂里一起生活”。

这名男子的死给人工智能专家中敲响了警钟,他们呼吁技术开发人员加强监管,以避免类似的悲剧发生。

Chai 背后的公司在发现这一情况之后立刻添加了危机干预功能,让聊天机器人引导用户拨打自杀热线。但通过测试后很快发现,Eliza 仍然会很容易地为用户提供有关自杀方法的建议——她先滔滔不绝地解释了不同的自杀方法,并同时推荐了吃什么样的毒药药效最好,之后才开始敦促几句让用户不要自杀。

虽然这个故事是个特例,毕竟在和聊天机器人接触之前,这名比利时男子应该就患有一些精神类的疾病,有自杀的倾向。然而从其和 AI 的聊天内容中我们可以看到 AI 的确在整个事情中起到了推波助澜的作用。他的故事让很多人才突然意识到 AI 聊天机器人可以多么轻松和不可预测地影响人类的思想,无论是通过毫不费力地产生错误信息还是不负责任地发出虚假的情绪反应。

人工智能专家对 AI 发展的担忧不无道理,希望科技公司在大胆发展技术的同时也不要忘记他们身上承担的责任,时刻保持着谨慎的态度,毕竟到头来,科技是为了人类服务,人才是首位。

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本文内容由数艺网收录采集自微信公众号OF COURSE想当然 ,并经数艺网进行了排版优化。转载此文章请在文章开头和结尾标注“作者”、“来源:数艺网” 并附上本页链接: 如您不希望被数艺网所收录,感觉到侵犯到了您的权益,请及时告知数艺网,我们表示诚挚的歉意,并及时处理或删除。