- 0

- 0

- 0

分享

- 论坛传真 | 正视人工智能引发的性别歧视

-

2022-12-16

在反歧视层面上,我们是否要对人工智能

赋予比人类更高的要求?

全球目前只有22%的人工智能专业人士是女性。人工智能越来越普遍的参与到影响我们生活很多方面的决策中。比如说人工智能告诉我们谁应该拿到工作面试的机会,谁能够获得银行信贷,将哪些产品推广给哪些消费者,甚至如何分配公共资源——哪些人应该获得社会福利,哪些街区该被定义为犯罪高风险地区等等。

尽管在预测与决策中使用人工智能可以减少人类的主观性,辅助人类进行理性决策,但人工智能也可能内嵌偏见,导致对某些人群的预测和输出不准确。例如,现有的性别偏见和不平等会被人工智能系统放大,在现实生活中给女性带来显性和隐性的负面影响。

近年来,人工智能中的偏见已逐渐受到各界关注。业界已经达成共识,指出人工智能系统中存在的性别偏见是不争的事实,并出台了一系列人工智能伦理原则与规范,以约束其表现。然而,这些准则往往停留在较高的概念层面,缺乏足够具体的技术标准和法律法规去支撑其落地,实际操作层面的改变。

因此,目前各个机构并不具备纠正人工智能偏见的工具与条件,但是随着人工智能越来越多影响我们生活的方方面面,我们必须正视这个问题,这不仅对于个人、企业,乃至整个社会来说都是不容小觑的。

从原则共识过度到治理监管层面的实操问题,敦促各利益相关方拿出具体落地的解决方案,恰恰是本次专题论坛致力于探讨的问题。

——张 薇

联合国开发计划署助理驻华代表

12月9日晚上9点到11点,由联合国开发计划署和联合国妇女署在“2022人工智能合作与治理国际论坛”合办的专题论坛4: 正视人工智能引发的性别歧视在线上举办。通过技术研究者、理论分析者和政策制定者之间的跨界讨论,聚焦以下问题:

人工智能系统中的性别偏见问题,重点探讨了造成人工智能性别歧视发生的关键因素及其造成的长期后果与影响。

人工智能的歧视治理,是否能、如何能与现有的公共治理分类相对应,如产品质量监管,风险管理,技术管理等。

明确人工智能歧视治理所需要的监管和治理任务,并基于任务来定义人工智能歧视的监管和治理技术,这包括:如何识别歧视风险?如何评估歧视的程度?如何追责?如何预防未来歧视的产生?如何加强监管与促进公众参与等。

如何制定出人工智能性别歧视的技术标准和要求以及配套政策。

本讨论环节由联合国开发计划署助理驻华代表张薇主持。

嘉宾精彩发言

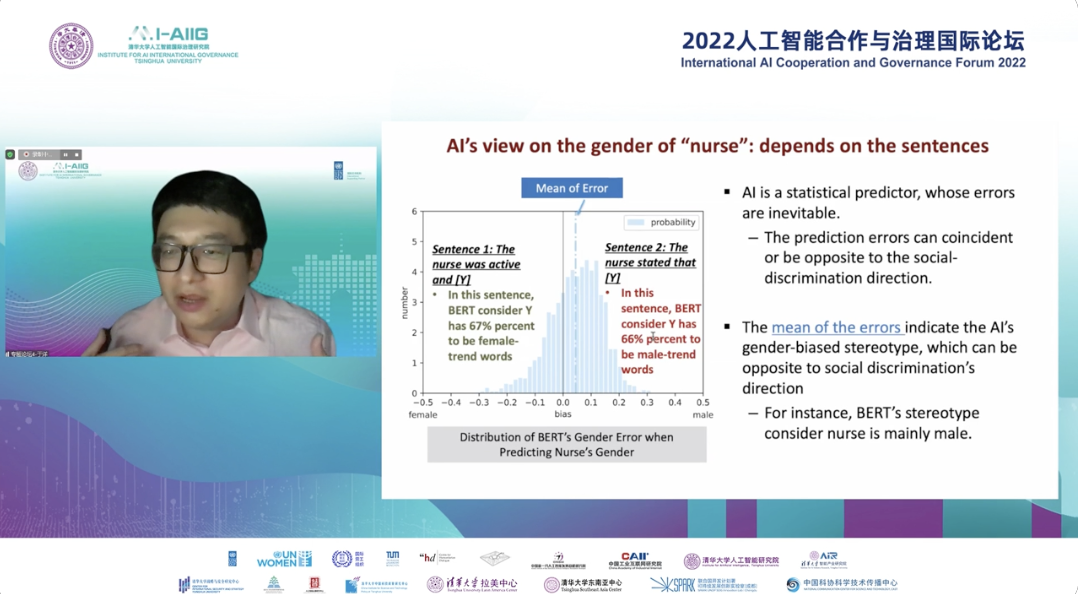

于洋首先展现了他和清华大学研究团队的研究成果:

开发了一个工具,用于识别、评估人工智能系统目前最常用的三大语言模型的性别歧视风险和歧视程度。

提出了一个方法,用于解析AI模型性别歧视风险是AI学会了人类的歧视、还是AI没有学会人类智能从而导致的偏误。

政策领域和技术领域的隔离,导致政策领域聚焦于原则而缺乏落实原则所需要的监管技术;相对应地,技术领域聚焦于具体任务中的歧视纠正,并没有为监管提供合适的技术支撑。因此,要在实践中实现人工智能性别歧视问题的治理,就需要政策、产业和研究领域对话。

我们认为政府可以做且必须做三件事。首先,为确保人工智能(AI)模型性别平等制定质量标准,包括零偏见标准,并将误差与社会歧视相同的可能性纳入考虑范围。

第二,政府应该鼓励甚至强制要求披露AI模型的性别平等质量,我们认为这应该是一种AI模型ESG审计的维度之一。

第三,政府应该推进抽样方法的标准化,以及评估AI模型性别公正质量方法的标准化。

——于 洋

清华大学交叉信息研究院助理教授、

清华大学人工智能国际治理研究院国际学术交流项目主任

人工智能作为人类开发出来的工具,一定体现了开发者或正面、或负面的价值选择,不存在绝对中立的技术。例如,一些商场会通过面部识别技术,向男性投放电子产品广告,向女性投放化妆品广告。我们可以看到,即便是在这样一个非常低风险的使用场景中,人工智能技术以一种隐蔽的方式将一些价值观念大规模地嵌入到我们的日常生活中,固化一些我们试图摆脱的性别偏见。以人工智能当前惊人的发展速度与使用规模,对于治理应该有更高的标准,不应该只关注高风险使用场景中可能发生的性别歧视和偏见。

——凯特琳·克拉夫布克曼

(Caitlin Kraft-Buchman)

Women at the Table CEO / 创始人 Alliance 联合创始人

要解决人工智能歧视问题,我们需要让人工智能系统更易理解。目前人工智能面临的最重要的伦理问题之一是,用户或者使用者往往不信任许多人工智能应用,包括AI推荐算法和AI医疗服务等。不信任源于不了解,人工智能仍是一个难以理解的黑匣子。例如,如果AI医疗软件提供的医疗服务只做出诊断决定,而没有给出诊断过程或提供相关信息,则可能影响医生对这些软件的使用和信任。面向未来,通过可解释的人工智能方法和解决方案,开发人员可以检测、识别和解决潜在的偏见歧视等问题。此外,促进人工智能的可解释性和可理解性,也可以支持用户的有意义的参与;如果用户能够理解AI系统,他们可以向开发人员提供反馈,也可以更有效地与人工智能系统进行协作。

——曹建峰

腾讯研究院高级研究员

女性在人工智能行业的代表性仍然不足,欧盟只有20%左右的女性进入了人工智能领域,中国的比例更低。2019年,清华大学计算机科学与技术专业学士学位的女性仅占12%左右,复旦大学的这一比例也是12%。这是一个系统性的问题,我们应该系统地加以解决,这就是为什么社会性别主流化如此重要。在技术设计的时候,一定要考虑到人,考虑到性别,才能使这项科技真的惠及人类。好的科技,能够使人类进步的同时,缩小男女差距;而没有考虑到人的科技,能够加大男女,以及强势和弱势群体之间的差距。

——马雷军

联合国妇女署驻华办公室

高级项目官员

为实现公平,我们需要了解数据的局限性,需要建立强大的测试系统,需要让客户和用户对局限性和数据测试知情。这关乎治理的全过程和批准权的行使。

在技术应用方面,有一些决策的影响力比其他决策更大。因此,我们有一个用户敏感问题决策程序,如果技术的使用将对身体、精神安全或福祉造成风险,或对资源、生命或人权产生重要影响,那么我们将启动一个额外的治理过程,让公司的专家来审查并签署额外的条款,以帮助做出一些风险较高的决定。

——莎拉·伯德(Sarah Bird)

微软Azure AI部门首席部门产品经理

依然很难在法律层面对人工智能的歧视或偏见做出界定,主要面临以下挑战:一 、造成人工智能歧视或偏见的原因很多,很难在法律条文中进行概括;二、人工智能的发展速度非常快,相关的规范很容易过时,难以对后来出现的歧视问题进行规制;三、研究表明,人们仍然缺乏相关知识理解算法如何运行,特别是那些极为复杂模型的运行原理。如果监管机构不了解AI,他们很难给出定义。如果立法机构给出不准确的定义,就会给整个行业带来伤害,扰乱秩序。

——张 欣

对外经济贸易大学

数字经济与法律创新研究中心执行主任

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本文内容由数艺网收录采集自微信公众号清华大学人工智能国际治理研究院 ,并经数艺网进行了排版优化。转载此文章请在文章开头和结尾标注“作者”、“来源:数艺网” 并附上本页链接: 如您不希望被数艺网所收录,感觉到侵犯到了您的权益,请及时告知数艺网,我们表示诚挚的歉意,并及时处理或删除。