- 0

- 0

- 0

分享

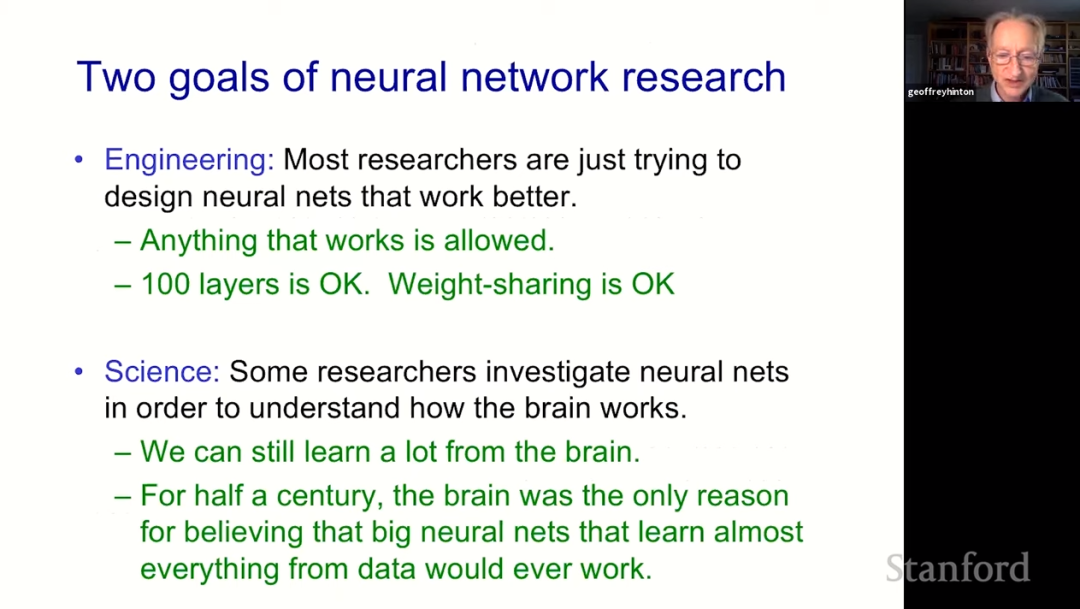

- Hinton坐阵!斯坦福CS25 Transformer专题讲座更新:多位AI大佬齐聚

-

2022-08-25

新智元报道

新智元报道

【新智元导读】斯坦福大牛Christopher Manning开设的Transformer联合讲座课程更新啦!这期请来的是Hinton大神。

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本文内容由数艺网收录采集自微信公众号新智元 ,并经数艺网进行了排版优化。转载此文章请在文章开头和结尾标注“作者”、“来源:数艺网” 并附上本页链接: 如您不希望被数艺网所收录,感觉到侵犯到了您的权益,请及时告知数艺网,我们表示诚挚的歉意,并及时处理或删除。