- 0

- 0

- 0

分享

- 5种新型人机交互技术

-

2021-01-09

本文转载自微信公众号:产品叨比叨

人机交互技术(Human-Computer Interaction, HCI)是指人与计算机之间以特定的方式,为完成确定任务人与计算机之间的信息交换过程。人类在许多方面与计算机进行交互,并且为了促进这种交互,人类和计算机之间的接口是非常重要的。

随着图形用户界面(Graphical User Interface, GUI)的不断发展,各种桌面应用软件、网页、移动端软件等已经融入到我们生活中。

语音识别和语音合成的语音用户界面(Voice User Interface, VUI)也逐渐被广泛应用。

近些年,随着可穿戴设备的发展,对人机交互提出了更高的要求:不仅让用户更好地控制设备,也需要让设备更懂用户。

01、眼控交互技术

眼控(Eye control)又称视线追踪、眼动追踪。

眼控技术原理:

当人的眼睛看向不同方向时,眼部会有细微的变化,这些变化会产生可以提取的特征,计算机通过图像捕捉或扫描等提取这些特征,从而实时追踪眼睛的变化,预测用户的状态和需求,并进行响应,达到用眼睛控制设备的目的。

眼控技术通常有三种追踪方式:一是根据眼球和眼球周边的特征变化进行跟踪;二是根据虹膜角度变化进行跟踪;三是主动投射红外线等光束到虹膜来提取特征。

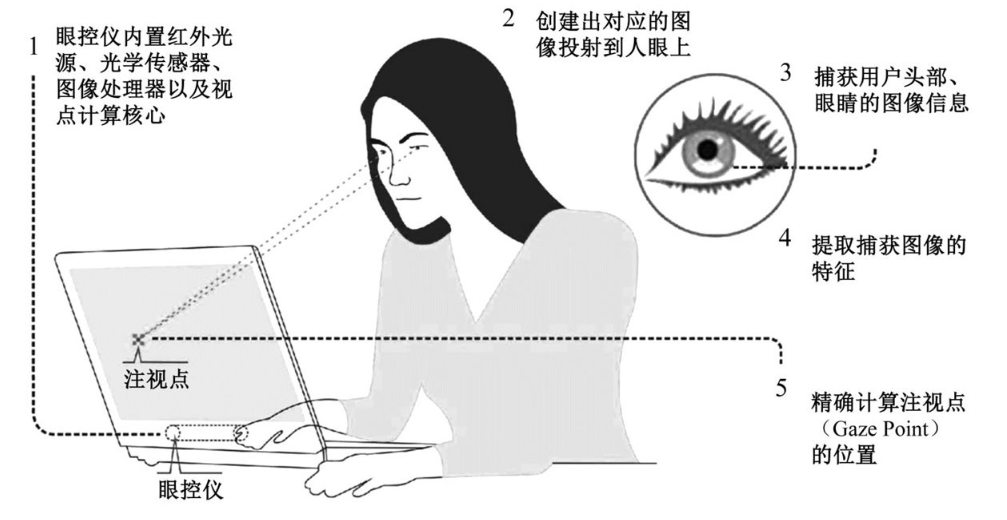

以第三种方式为例:如下图,首先图中位置1所示的眼控仪发出近红外光束投射到人眼上,根据发射光束和从人眼反射回的红外光计算得到参考点,当人眼注视屏幕上不同位置时,眼球会相应地发生转动,此时反射回的光就会产生一定的偏移,根据偏移方向、偏移量大小等信息计算得到眼球运动轨迹和状态,结合眼周的图像信息可进一步计算得到眼睛注视点的位置。眼控技术含量最高的是自动校正系统,避免人工调节的繁琐,通过算法优化,提升光学采集精度,还要实现视线追踪,判别眼睛睁、闭状态等。

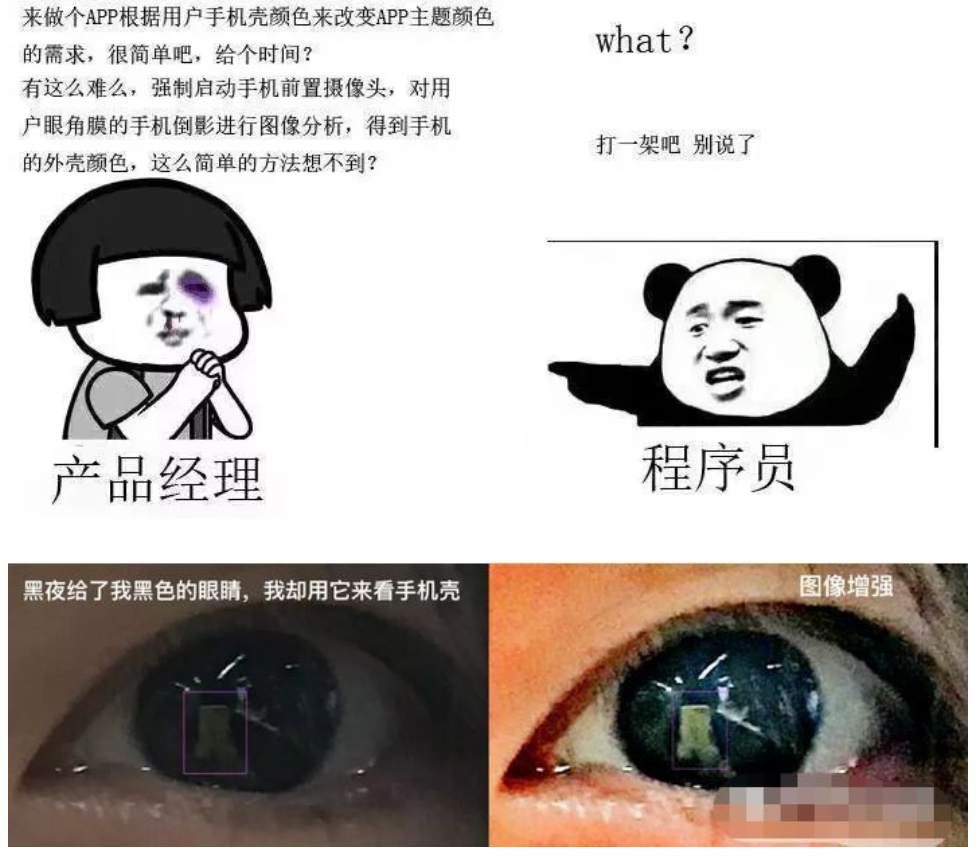

看到这,你想到了什么?

也许……还真能实现……

02、体感交互技术

体感交互技术是指将肢体语言,转化为计算机可理解的操作命令来操作设备。

其中手势交互最具代表性,各类传感器对手部形态、位移等进行持续采集,每隔一段时间完成一次建模,形成一个模型信息的序列帧,再将这些信息序列转换为对应的指令,用来控制实现某些操作。

例如最近火热的游戏,健身环大冒险

体感交互技术原理:

主要可分为三大类:惯性感测、光学感测、惯性和光学联合感测:

(1)惯性感测:主要是以惯性传感器为主,例如用重力传感器、陀螺仪以及磁传感器等来感测使用者肢体动作的物理参数,再根据这些物理参数来分析出使用者在空间中的各种动作。

(2)光学感测:主要是通过光学传感器、或者使用激光及摄像头来获取人体影像信息,可捕捉人体3D全身影像。

(3)联合感测:代表厂商为Nintendo及Sony。主要是在手柄上放置重力传感器、陀螺仪、磁传感器等,结合摄像头,摄像头用于捕捉人体影像,结合这传感器,便可侦测人体手部在空间中的移动及转动。

03、VR/AR交互技术

VR(Virtual Reality),即虚拟现实技术。是利用电脑模拟产生一个三维空间的虚拟世界,提供使用者关于视觉、听觉、触觉等感官的模拟,让使用者如同身历其境一般,可以及时、没有限制地观察三度空间内的事物。

例:VR游戏设备

VR实现原理:

(1)三维图像。利用计算机建模产生立体的图形图像,比如驾驶模拟系统中模拟的周围公路、建筑物等图像。

(2)显示。人看周围的世界时,由于两只眼睛的位置不同,得到的图像略有不同,这些图像在脑子里融合起来,就形成了一个关于周围世界的整体景象,这个景象中包括了距离远近的信息。当然,距离信息也可以通过其他方法获得,例如眼睛焦距的远近、物体大小的比较等。在VR系统中,双目立体视觉起了很大作用。用户的两只眼睛看到的不同图像是分别产生的,显示在不同的显示器上。有的系统采用单个显示器,但用户带上特殊的眼镜后,一只眼睛只能看到奇数帧图像,另一只眼睛只能看到偶数帧图像,奇、偶帧之间的不同即视差就产生了立体感。

(3)用户(头、眼)跟踪。通过用户头戴设备内的陀螺仪,当人转动头部时,陀螺仪能够及时感知人头部的变化情况,此信息传递给图像生成引擎,及时更新画面,从而使人感觉到,自己是在看一个环绕的虚拟空间,从而产生360°的三维空间感。

(4)声音。常见的立体声效果就是靠左右耳听到在不同位置录制的不同声音来实现的,所以会有一种方向感。利用该原理,VR系统通过给两只耳机传输有差异化的声音,从而让耳朵感受到身临其境的立体声效果。

(5)触觉。在一个VR系统中,用户佩戴的手套内层安装一些可以振动的触点来模拟触觉。用户可以看到一些虚拟的物体(比如杯子)。你可以设法去抓住它。

AR(Augmented Reality),即增强现实,也被称为混合现实。是通过计算机系统提供的信息增加用户对现实世界感知的技术,将虚拟的信息应用到真实世界,并将计算机生成的虚拟物体、场景或系统提示信息叠加到真实场景中,从而实现对现实的增强。AR通常是以透过式头盔显示系统和注册(AR系统中用户观察点和计算机生成的虚拟物体的定位)系统相结合的形式来实现的。

例:马里奥AR赛车

AR实现原理:

通过计算机技术,将虚拟的信息应用到真实世界,真实的环境和虚拟的物体实时地叠加到了同一个画面或空间同时存在。它不仅展现了真实世界的信息,而且将虚拟的信息同时显示出来,两种信息相互补充、叠加。在视觉化的增强现实中,用户利用显示设备,把真实世界与计算机图形多重合成在一起,便可以看到真实的世界围绕着它。增强现实借助计算机图形技术和可视化技术产生现实环境中不存在的虚拟对象,并通过传感技术将虚拟对象准确“放置”在真实环境中,借助显示设备将虚拟对象与真实环境融为一体,并呈现给使用者一个感官效果真实的新环境。

04、骨传导交互技术

骨传导交互技术主要是一种针对于声音的交互技术,将声音信号通过振动颅骨,不通过外耳和中耳而直接传输到内耳的一种技术。骨传导振动并不直接刺激听觉神经,但它激起的耳蜗内基底膜的振动却和空气传导声音的作用完全相同,只是灵敏度较低而已。

骨传导技术优势:

无辐射危害,由于骨传导设备的主要部件骨振器是一个纯机械的振动部件,因此不存在电磁波对人脑的潜在辐射危害。

抗干扰,由于骨传导不需要空气作为媒介,因此在强烈噪声环境下仍会有较高的清晰度。

不损伤听力,骨传导不是直接通过音量放大来提高收听效果,因此不会对听力造成损伤。

不影响接收环境中其他声音,骨传导收听方式不占用耳道,使用者在收听骨传导声音的同时,还可以听到周围环境的声音,既安全又舒适,更适用于一些特殊的场合。

05、脑波交互技术

脑波交互技术主要是通过对人的脑电图(Electroencephalograph, EEG)进行采集和预处理(滤波等)、特征提取以及模式识别之后判断出人当前的意图,并将识别结果发送给计算机进而控制计算机本身的软件(比如游戏)或者外部的硬件设备(比如电视机)。

脑波技术作为一种探索中的技术,因为信号转换和信号传输效率问题,还有很长一段路要走,期待未来可以更多应用于残疾人的辅助控制。

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本文由 数艺网 授权 数艺网 发表,并经数艺网编辑。转载此文章请在文章开头和结尾标注“作者”、“来源:数艺网” 并附上本页链接:https://www.d-arts.cn/article/article_info/key/MTE5NzgxMDE0MDmEqZdosYOgcw.html 本站部分文字及图片来源于网络,如侵犯到您的权益,请及时告知,我们将及时处理或删除。