- 0

- 0

- 2

分享

- 从黑白,到彩色,再到3D,视觉技术一直在追赶人类的眼睛 | 造就Talk·朱力

-

原创 2020-10-14

本文来源于:造就

过去几千年,大多数人只能参与历史,记录是少数人的权力。而随着技术的提升,每个人不仅在参与历史,也在记录着历史。

《窗外的风景》 乔瑟夫·尼舍弗朗·尼埃普斯 1826

这是1826年,法国的发明家尼尔普斯,在他的工作室拍下的《窗外的风景》,这是人类历史上第一张永久性流传下来的照片。所谓永久性,就是它记录在了一张相纸上,这是第一张照片。

从200年后的视角来看,这个图片缺少了太多的信息——

这个图片很不清楚,我们不知道它拍了什么;

图片没有颜色,只有黑与白;

图片缺乏动态,因为它是一个静态的东西。

在这之后的100年,发明家们不断地努力去追赶我们人类的眼睛,感知世界的维度。

朱力

光鉴科技创始人兼CEO

下载造就APP,观看完整演讲

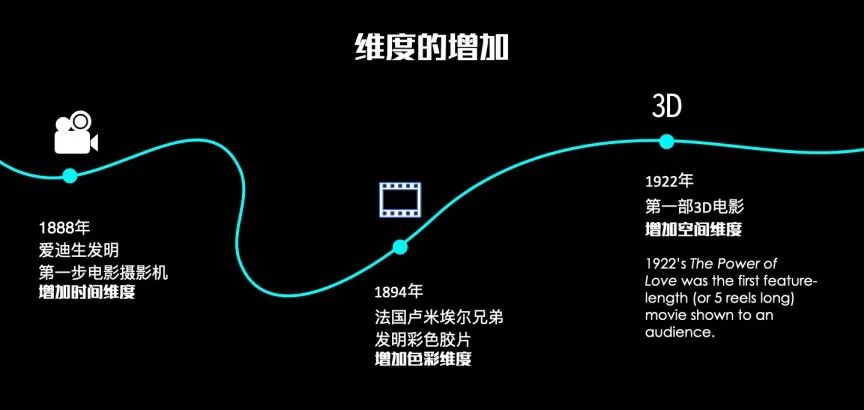

1888年,爱迪生发明了电影机。原理很简单,就是把一系列的胶片快速地转起来,我们就可以看到一个动态的画面,这样我们可以记录时间。

1894年,彩色的胶片出现,我们终于可以把世界的颜色记录下来。

1922年我们有了第一部3D的电影,叫做《The Power of Love》,这个时间点比大多数人想象的要早很多。

其原理与现在去电影院看的3D电影有点不一样,当时是用两个摄影机,一个是拍红色,一个是拍绿色,大家看的时候有一副眼镜,分别是红绿看不同的画面,这样画面的叠加就有了立体的效果。

当时为了达到3D效果,牺牲的是画面的色彩丰富程度。

视觉技术的发展

这是第一个100年,我们追赶着人类所感知到的世界所有的维度。而在过去20年,绝大多数人经历了从胶片到数码时代的变革,这是一个颠覆性的变化。

胶片时代,我们拍照的时候需要在意胶卷还有多少张、冲洗的时间是多久、相册的厚度是多少,因为每张照片都占据空间。

在数码时代,我们拍照的时候,可以立刻看到自己拍的图像,在瞬间就可以复制,分享给其他人,而且成本几乎可以忽略不计。

这奠定了移动互联网社交网络的基础,我们可以无限制地去创造和分享看到的信息,只需要关注自己想记录下的画面,然后把它分享出去,剩下的由数码和技术来解决。

视觉技术的进一步升级,让每个人、每个消费者的手机上,口袋里都有一个相机,给社会带来了非常本质的变化。

仅仅在十几年前,在我上大学的时候,当时媒体的定义是少数的机构,它可以是电视台,可以是报纸,可以是杂志,但不是我们每一个人。

现在当我们把手机,把摄像头连接上互联网以后,每一个人都可以成为事件,或者环境的记录者和分享者。我们的所见所闻可以立刻发到网上,所有人都可以看到。甚至有一些大V在做直播的时候,可以一瞬间,同时与几百万、上千万的人互动,这是视觉技术升级带来的力量,它甚至改变了历史的发展和记录的形式。

在过去几千年甚至一两万年人类历史的演进过程中,大众是历史的参与者,只有少数人才有记录历史的权利。而在今天,此时此刻,我们每一个人不仅在参与历史,而且可以记录历史。

过去,我们是用大量数据解决小问题,而利用3D视觉,可以用很小的数据量解决更大的问题。

过去我们拍的图片、视频,最终的“受众”是人,需要人自己处理。但是在过去的十年,AI技术快速发展,大量数据的“受众”已经不再是人,是机器,是算法。

机器已经开始替代人去做很多重复性的劳动,比如海底捞等餐厅,送餐机器人在餐厅里走来走去,或者在酒店、机场,已经有机器人给我们提供服务,而每个机器人每个月都可以为使用者节省几千元的劳动力的成本。

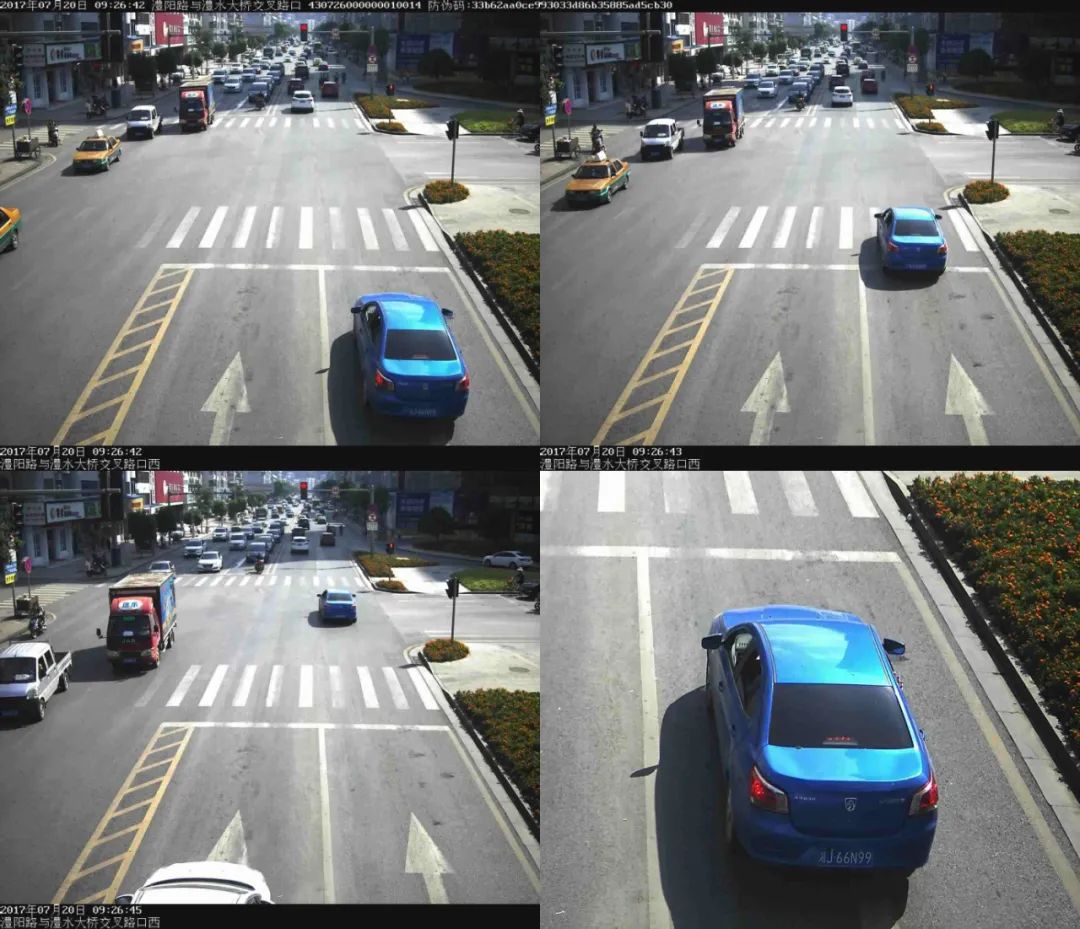

交通监控

还有交通监控,现在24小时交通监控的背后是算法在不断地在跑,一旦有人违章,路口的屏幕就会显示某车牌号,出现了超速或者其他违规情况。这些技术代替了大量的生产力,帮我们创造了更多新的价值。

那么,这与视觉技术有何关系呢?

过去的十年,机器视觉主要基于2D图像。它只有平面,但世界是三维的,这就意味着我们需要用低维度的画面描述更高维度的信息,所以现在是用大量的数据解决更小的问题。

比如,桌上有一个杯子,如果要用2D图像去描述它,我们需要在不同的距离,不同的角度,拍很多图片,才能组合在一起,再通过一系列算法进行重建。

在学术圈用的比较多的数据库是ImageNet,里面有1000多万张图片,但只有一万多个,接近两万个类别。我们训练一个基础识别算法,需要上千张的图片,这仅仅是满足学术的要求。

对于实际应用的产品,比如大量使用的监控、人脸识别等,我们需要几百万、几千万,甚至上亿张图片才能建立起一个真正好用的模型。这意味着,想要用AI和视觉做好结合,我们需要大量的数据。而数据的采集,数据的标注都是非常大的成本。

但3D图像可以非常简单的通过几张图就能描绘清楚一个物体,通过三个视角就能非常清楚的去表征一个物体的空间信息,我们就可以用一个非常小的数据来解决更大的问题。

与20年前相比,当下的3D相机成本从过去的几万、几十万,下降到了几十块钱,为什么?主要得益于三方面的技术突破。

第一是激光技术。

过去的3D相机主要是基于双目或多目,比如几个摄像头同时去拍摄,有一个立体的视角把3D的环境重建出来。

现在,更好、更稳定的3D技术用的是激光,我们可以发射一个有图案分布的激光,然后再拍摄,通过立体分布,或者通过光脉冲来回的时间,可以得到我们想要的空间立体的信息。

但在20年前,激光器非常贵,整个光学系统也非常贵。好的镜头是一个非常大,非常重,并且非常昂贵的东西,激光器也是。2017年iPhoneX量产了第一代的3D结构光摄像头,在这一年中,仅仅这一个场景,人类制造了超过400亿个激光器。

400亿是什么概念?它超过了过去人类历史上所有的年份生产的激光器的总和。而在这400亿个激光器里面,每个激光器的价格才不到一美分。

第二个技术突破是光学和集成电路、半导体技术的结合。

通过半导体制程的优化,从几微米到现在7纳米、5纳米,把大量的电路晶体管集成在了一个非常小的芯片上。而这个工艺的演进也同时帮助了光学发展,我们可以把很多的光学功能,诸如透镜等衍射、光栅的功能集成在一个很小的器件上。

过去的3D相机是一个设备,现在的3D相机就是一个非常小的模组,可以嵌入到手机里。基于这两种技术的快速迭代发展,才能把相机变得非常小,放到我们的口袋里,而且变得非常便宜。

第三个就是AI技术的发展。我们有了3D相机,就需要有一个计算的能力去理解我们看到的场景。AI过去十年的发展做了非常好的铺垫。

当我们口袋里有一个3D相机以后,我们可以做很多有意思的事情。大家用的iPhone或华为手机,前面都有3D相机,它的核心的作用是理解用户,帮助设备感知用户是谁。

比如FaceID的解锁、支付,使用3D技术可以更安全、更高精度的去识别这个用户是谁。

更进一步,可以去观察人的微表情——你的眉毛是不是往上耸了,你的嘴角是不是往上翘了,那是说明你高兴了;你的嘴角往下了,说明你不高兴了。这些细节,可以与Animoji等应用结合起来与人做交互,这是前置摄像头。

而手机的背后,现在已经有ToF的相机在华为上广泛使用。iPad,以及未来即将发布的iPhone上也会有3D相机,可以用来帮助设备去和空间做交互。它可以看到五米甚至十米远,可以通过视觉帮助定位手机。

比如,将虚拟世界的画面与真实世界的画面融合,就意味着是AR。也可以用来做定位,做SLAM等很多有意思的应用。

更进一步,几年以后,当我们每个人手里都有一个3D相机的时候,每个人都在不断的拍摄和记录真实世界的每一个角落。这就好像我们玩游戏开地图一样,这个世界本来全都黑暗的,每个人拍个照片就进入了一个角落,而把这些角落拼接在一起,我们就将整个真实世界数字化了。

在这之后,我们可以去体验一个“虚拟的真实世界”,电影《头号玩家》的那些体验,其实在不远的将来可能就会成为现实。

我们不能把所有的问题都扔到云端,虽然我们有更好的带宽,更好的算力,但不代表可以滥用这些东西。

3D视觉与2D视觉的本质区别在于什么?

举一个例子,现在去银行里开户,我们不需要去柜台,一个自动柜员机会帮助你解决所有流程。首先需要解决的就是你到底是不是“这个人”,2D的场景可能用一张照片,然后用照片对着摄像头就很容易攻破这个系统。

如果要判断这个是不是“真人”,2D的解决方案是让用户摇头、点头、眨眼等等。在进行健康码验证的时候,屏幕闪烁不同的颜色,有些需要你报一串数字等等。这是一个非常复杂的、用户体验不佳的,并且很长的过程。它需要几秒,甚至几十秒的时间,把这些的数据传到云端,用一个很复杂的模型来去判断。

银行智慧柜员机

现在,通过端上的3D相机可以直接拍到人的立体信息,可以拍到很多立体细节,这些细节可以帮助我们在端上用一个几美金的芯片,跑一个非常轻的算法就能实现这样的功能。也就是说,我们可以把很多复杂的,需要云端处理的问题,搬到了一个摄像头里面。

可能有人会问,加了3D相机,是不是增加了额外的成本?其实从“云”到“端”上的转变、迁移,解决了两个非常关键的问题——

在IoT的时代,设备会越来越多。目前,世界上正在运行的IoT设备有数十亿个,在五到十年之内会增长到数百亿个,我们预计50年以后会有400亿以上的IoT设备。

当这些IoT设备不断采集图像、视频时,按照现在的架构,把所有的任务交给云端,面临的第一个问题就是带宽够不够?第二个问题就是电够不够?

由于5G的出现可能带宽的问题会得到解决,但是如果不改变架构,每年仅通讯和云端这部分计算IoT,就要用掉未来全世界20%的电力,同时会产生环境等额外一系列问题。

所以我们需要把这个问题简化,不能把所有问题都扔到云端。我们有更好的带宽,更好的算力,但这不代表我们可以滥用这些东西。

我们需要在端上做好感知,用更高密度的数据进行理解。更重要的问题是——我们可以通过技术解决功能,可以让生活变得更便捷。

但是,人能不能接受这种方式?这不一定,我们希望有机器人一类更便捷的方式服务我们,但是并不希望有机器的摄像头,一天到晚盯着自己,个人的隐私安全是一件非常重要的事情。

如果这个问题不解决,必然会导致人们不用这个技术,那么它就毫无价值。所以我们必须把图像数据封装在端上,当数据采集完成后,在端上进行算法处理,通过加密再发出去。

如果黑客攻破这个数据的话,这将是一个毫无意义的向量,从物理上不再需要担心数据安全的问题。这也是技术服务于人,服务于社会的最根本的前提。

大家有没有想过,为什么摄像头是彩色的?

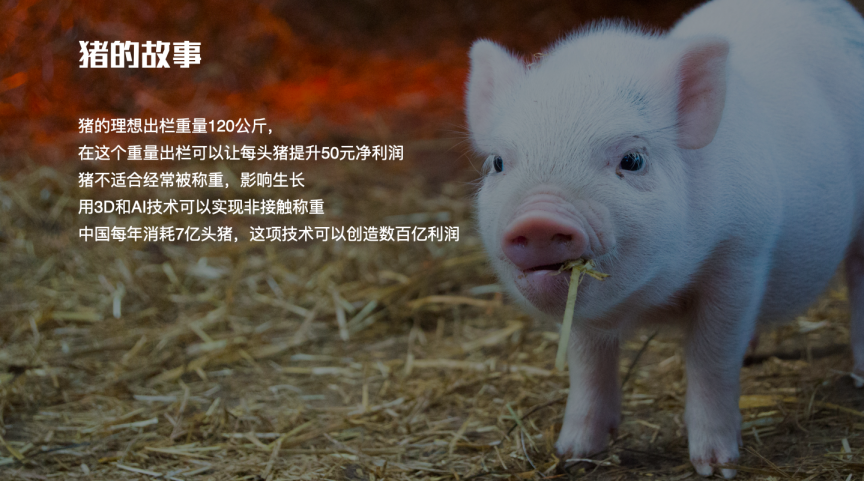

我们讲了那么多加密、信息安全技术,现在调转一下画风,讲一个猪的故事。

中国是全世界吃猪肉最多的国家,一年要吃掉约7亿头猪。猪的最优出栏体重是120公斤,超过120公斤,再给它吃饲料,长肉就比较少了,不划算。

如果有一个技术,能够帮助畜牧行业非常准确的控制每只猪都在120公斤出栏,那就可以使每头猪增加50元的利润,7亿头就是350亿人民币的利润。

但我们并不能频繁的把猪赶到秤上称一称,因为猪是一个非常敏感的动物,如果强迫它做什么事情,它会不高兴,不高兴它就不吃饲料,就会导致它不长肉,所以我们需要以非接触的方式测量猪的体重。

这时,我们就可以使用3D相机去测量猪的三围,比如腰围、颈围、臀围,以及四肢的维度,然后结合合作伙伴大数据与猪的品种进行分析,可以非常准确的预测猪的体重。简单的技术升级,就可以创造非常多的价值。

为什么要和大家分享这个故事?其实是想告诉大家,3D视觉与2D视觉有一个非常大的差异。2D视觉的大量数据最初的受众是人,我们把图片、视频拍下来,由人去分析。

因为人的学习速度非常快,只要摄像头技术也成熟了,那么,视觉「技术的成熟」与「应用的成熟」几乎是同时发生。

但是3D技术不一样,3D技术对应的是算法和场景。2016年,相关行业开始尝试做刷脸支付,而真正大量普及是在2019年。花了三年时间才把整个链条打通,让整个行业开始普遍应用3D技术。也就是说,3D相机的成熟,需要与行业磨合一段时间,产生一个成熟的方案,然后再落地。

这也是为什么现在3D技术发展,是一个一个行业在发生的,从关键任务慢慢发展到非关键任务,从更有钱的场景,比如金融、安防、工业等场景,发展到更多的民用场景。

随着场景不断落地,3D相机成本不断降低,技术不断成熟,应用算法不断的完善,3D视觉的发展速度也会越来越快。最近几年,每年有5-10个场景出现,可能三年以后,每年有50-100个场景出现,到最后,所有机器视觉的场景都会是3D的。

那么,大家有没有想过,为什么摄像头是彩色的?

——因为世界就是彩色的。

当我面对很多合作伙伴,面对很多投资人的时候,每次都会提到同一个问题——我为什么需要3D?现在2D用得不是很好吗?为什么我要额外花钱去买3D相机?

如果我们从一个更远的维度去看,这个世界本来就是3D的,我们为什么要退回到一个平面上?

原来,之所以用2D的平面,是因为我们没有能力去采集3D数据,而现在3D技术已经成熟,我们用几十块钱就能做一个很好的3D相机,那么,未来所有的摄像头自然而然也都会是3D的。

有了3D以后,我们可以有更直接的交互。开头提到的第一部3D电影的名字叫《The Power of Love》——爱的力量,如果要感受爱的力量,我希望看到的人是立体的、栩栩如生地站在我的面前。

我们也希望通过3D技术能够让感知变得更智能,在端上、在摄像头上就实现分析和理解。这就像人一样,我们不会去「思考」自己到底看到了什么,摸到了什么,五官的感知已经在我们的潜意识里都解决了。

而思维是在决策维度才用到的,当获取这些信息以后,如何去思考、分析、决策。

在万物互联的IoT时代,我们需要把更低成本、更高效、更安全的架构实现出来。我们需要在端上实现感知,在云端实现分析与判断。

(本文未经造就授权,禁止转载。)

编辑 | 王锐;视频 | Don

版面 | 田晓娜

欢迎扫描下方二维码,勾搭小编

或直接添加造就小助手(zaojiu16)微信

发送暗号“课程”混各种有趣有料的课程社群

-

阅读原文

* 文章为作者独立观点,不代表数艺网立场转载须知

- 本文内容由数艺网收录采集自微信公众号造就 ,并经数艺网进行了排版优化。转载此文章请在文章开头和结尾标注“作者”、“来源:数艺网” 并附上本页链接: 如您不希望被数艺网所收录,感觉到侵犯到了您的权益,请及时告知数艺网,我们表示诚挚的歉意,并及时处理或删除。